Das „Moral Machine Experiment“

Mensch und Maschine, Leitung Prof. Iyad Rahwan

Die rasante Entwicklung der Künstlichen Intelligenz birgt viele positive Potenziale, wirft aber auch drängende Fragen auf. Einer dieser Fragen gehen wir in unserer weltweiten Studie „Moral Machine“ nach.

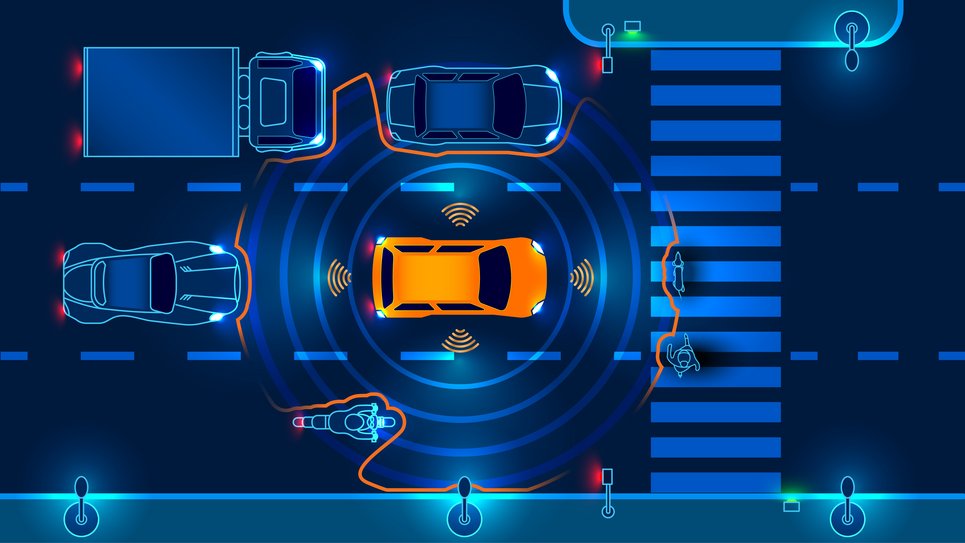

Im Verkehr, einer unserer alltäglichsten Situationen, testen wir bereits Künstliche Intelligenz in Form von autonom fahrenden Autos.

Die Vision ist klar: nachhaltiger, sicherer und stressfreier Verkehr. Doch was passiert, wenn die KI in einer Gefahrensituation plötzlich über Leben und Tod entscheiden muss? Wie geht sie mit moralischen Dilemmata um, wessen Leben soll im Zweifelsfall gerettet werden? Bevor wir eine KI in die Lage versetzen, solche schwerwiegenden Entscheidungen zu treffen, müssen wir uns über unsere Erwartungen klar werden: Welche ethischen Prinzipien sollen das Verhalten von Maschinen leiten?

Auf der Studienwebseite „Moral Machine Experiment“ , sollen die Besucher*innen ihre Entscheidungspräferenzen zu verschiedenen Szenarien geben, denen die Fahrenden eines selbstfahrenden Fahrzeugs ausgesetzt sein könnten. 40 Millionen Entscheidungen in zehn Sprachen von Millionen Menschen aus 233 Ländern und Territorien waren die Datenbasis. Das Ergebnis dieser Studie legt die Grundlagen für weitere Forschung über die Präferenzen bei ethischen Entscheidungen, die im globalen Kontext durchaus divers sind.

Weitere Forschung und Diskussion sind nötig um herauszufinden, welche globalen, gesellschaftlich akzeptablen Prinzipien für die Ethik der Maschinen gelten sollen. Diese Prinzipien stellen die Grundlage für Unternehmen dar, die moralische Algorithmen für Künstliche Intelligenz entwerfen und sollen auch eine Richtschnur für die politischen Entscheider sein, die diese Algorithmen regulieren.